È il dicembre 2017 quando la giornalista statunitense Samantha Cole scova sul forum Reddit il primo deepfake che gira in rete. È un video che riproduce l’attrice e modella israeliana Gal Gadot mentre ha un rapporto sessuale.

Le immagini non sono precise, il volto non sempre combacia con il corpo e, quando si mette in play, il video genera il cosiddetto effetto uncanny valley, ovvero quella sensazione di disagio che si prova quando si osserva un robot con caratteristiche umane non del tutto realistiche.

Come racconta Cole nell’articolo, “deepfakes” – questo il nome dell’utente – continuerà a pubblicare altri video generati con l’intelligenza artificiale e manipolati con contenuti espliciti: una volta con il volto di Scarlett Johansson, un’altra con quello di Taylor Swift. Il fatto che siano persone famose permette di avere più materiale fotografico e video da “dare in pasto” allo strumento e ottenere così un risultato il più possibile verosimile. Ma l’essere note al grande pubblico non è il solo tratto che le accomuna: tutte le persone colpite da deepfake sono donne, e tutte vengono spogliate e riprodotte in pose sessualmente esplicite senza esserne a conoscenza, e quindi senza aver dato il proprio consenso.

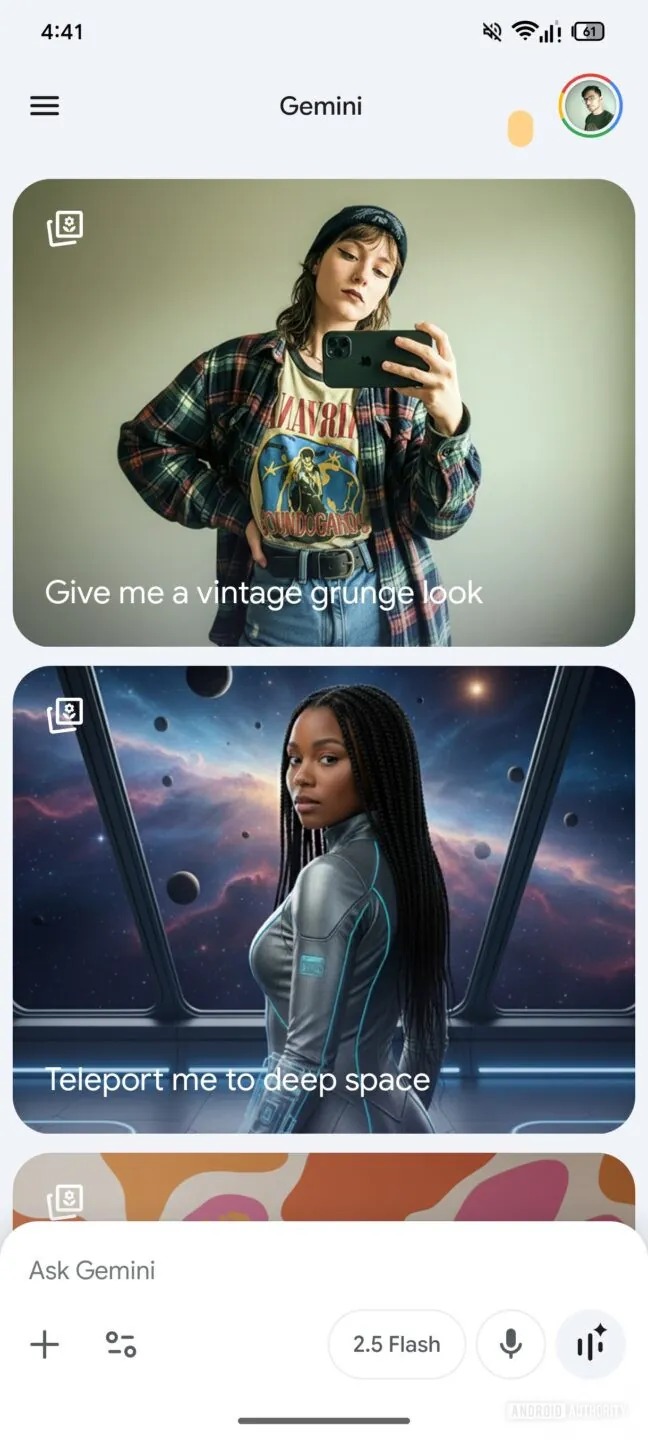

In appena qualche anno, i deepfake sessuali – anche noti come deepnude – sono diventati un fenomeno in preoccupante espansione in tutto il mondo. Senza più quelle “imprecisioni” che li caratterizzavano ancora nel 2017, oggi riescono a manipolare l’immagine a partire da una sola foto.

Anche in Italia se ne parla sempre più frequentemente, come dimostra la recente denuncia di Francesca Barra. Il 26 ottobre, la giornalista e conduttrice televisiva ha scritto un lungo post su Instagram dove racconta di aver scoperto che alcune immagini di lei nuda, generate con l’intelligenza artificiale, circolano da tempo su un sito dedicato esclusivamente alla condivisione di immagini pornografiche rubate o manipolate con l’IA. “È una violenza e un abuso che marchia la dignità, la reputazione e la fiducia”, ha scritto nel post Barra, che si è detta preoccupata per tutte quelle ragazze che subiscono la stessa violenza e che magari non hanno gli stessi strumenti per difendersi o reagire.

I casi nei licei italiani

In effetti, casi analoghi sono già scoppiati in diversi licei in tutta Italia. A inizio anno, quattro studentesse di un liceo scientifico di Roma hanno ricevuto foto prese dai loro account Instagram in cui apparivano completamente nude. A manipolare le immagini è stato un loro compagno di classe, a cui è bastato caricare le foto su un bot su Telegram che in pochi istanti ha “spogliato” le ragazze.

La Procura di Cosenza starebbe invece indagando su un altro caso che, secondo le cronache locali, arriverebbe a coinvolgere quasi 200 minorenni per un totale di 1200 deepnude. La dinamica è sempre la stessa: attraverso bot Telegram e strumenti online, studenti maschi hanno manipolato le foto delle loro compagne di classe.

Secondo un’analisi condotta nel 2023, il 98% dei deepfake online registrati quell’anno (95.820) era a contenuto sessuale. Nel 99% di questi, la persona colpita era donna. Insomma, già quel primo video su Reddit preannunciava un utilizzo di questi strumenti volto quasi esclusivamente a quello che, in inglese, è stato inquadrato come image-based sexual abuse (IBSA), un abuso sessuale condotto attraverso l’immagine.

“Intorno alla violenza digitale rimane sempre un po’ il mito che sia in qualche modo meno reale rispetto alla violenza fisica. Ma non è affatto così”, spiega a Guerre di Rete Silvia Semenzin, ricercatrice in sociologia digitale all’università Complutense di Madrid. “Le vittime di deepfake subiscono le stesse identiche conseguenze delle vittime di condivisione di materiale sessuale non consensuale. Quasi sempre, la violenza è continuativa e intrecciata nelle sue varie declinazioni, quindi alle molestie, allo stalking, ecc. A mio avviso, con i deepfake si entra in una fase della violenza in cui diventa anche più manifesta la volontà di controllo sul corpo femminile. Perché le radici del fenomeno sono di tipo culturale e affondano sempre nella volontà di sopraffazione del soggetto femminile da parte degli uomini, in questo caso attraverso l’utilizzo della tecnologia”.

La complicità delle piattaforme

I canali su cui vengono generati e diffusi maggiormente i deepfake sessuali sono generalmente siti anonimizzati che sfruttano hosting offshore e che non rispondono alle richieste legali di altri stati. Quello su cui Francesca Barra e altre donne dello spettacolo hanno scoperto i loro deepfake (di cui non faremo il nome per non dare maggiore visibilità) è attivo già dal 2012, anno di registrazione a New York. Se i contenuti presenti sono sempre materiali espliciti non consensuali, trafugati dai social media o da piattaforme pornografiche come Pornhub e OnlyFans, in cima all’interfaccia utente spiccano invece gli strumenti che permettono di creare con l’intelligenza artificiale la propria “schiava sessuale”. Questa scelta rivela come l’“offerta” all’utente non solo comprenda i deepnude, ma li consideri anche il “prodotto di punta” con cui invogliare all’utilizzo e ampliare la platea di visitatori.

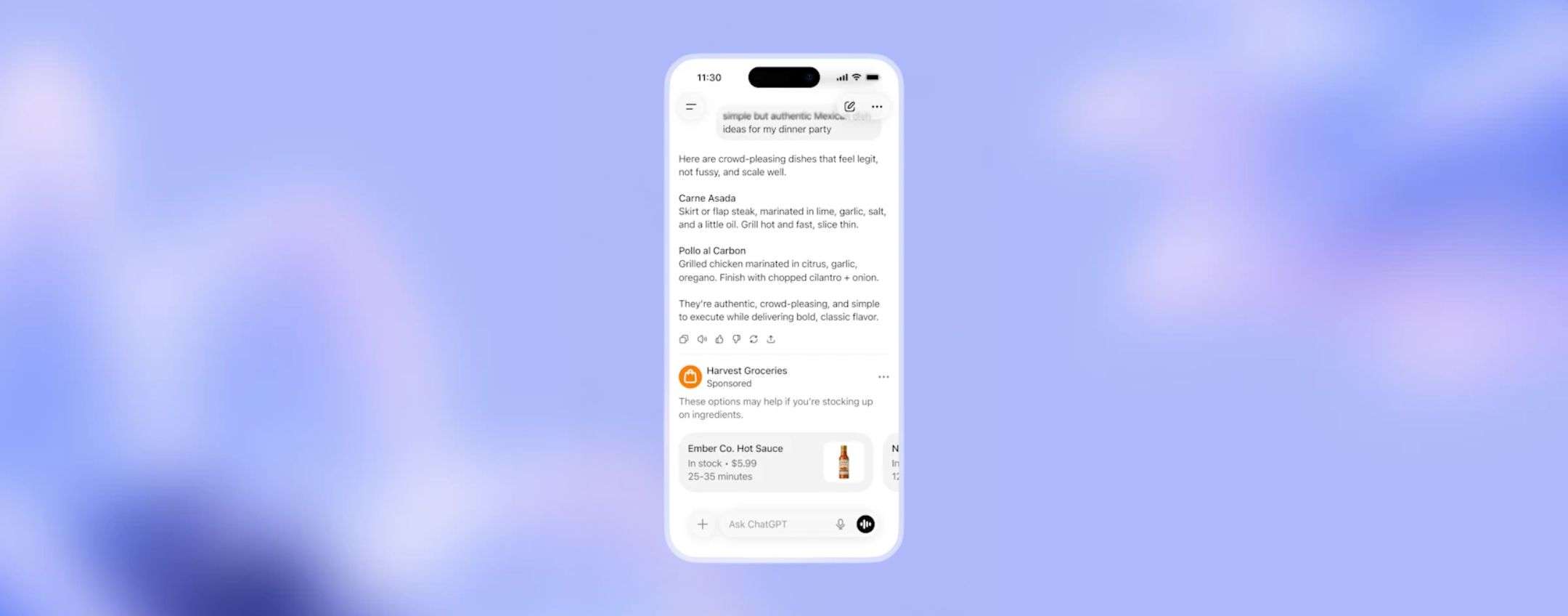

Silvia Semenzin e la collega Lucia Bainotti, ricercatrice in sociologia all’Università di Amsterdam, nel 2021 hanno pubblicato un saggio dal titolo Donne tutte puttane, revenge porn e maschilità egemone. Oltre ad anticipare già il tema dei deepfake sessuali, le due autrici in quel testo tracciavano il modo in cui l’architettura dei siti e delle piattaforme su cui vengono diffuse maggiormente immagini sessuali non consensuali possa essere complice dell’abuso fornendone gli strumenti. In particolare, la ricerca era incentrata sui gruppi di persone che condividono materiale non consensuale soprattutto su Telegram, app di messaggistica dove si muovono ancora adesso molti dei bot capaci di spogliare la donna in un solo clic.

La possibilità di creare canali con molti utenti, assieme alla facilità di archiviazione nel cloud della stessa piattaforma e alla percezione di agire nell’anonimato sono alcune delle funzioni che garantiscono la continuità delle attività e rendono praticamente impossibile fermare la proliferazione di deepfake e materiale intimo non consensuale.

Tutte queste funzionalità socio-tecniche, chiamate affordances (inviti all’uso) possono essere considerate “genderizzate”, perché vengono utilizzate in modo diverso a seconda che l’utente sia uomo o donna, contribuendo così a costruire la propria identità di genere. Per questo motivo – spiegano le due ricercatrici – l’architettura di Telegram può risultare complice nel fornire gli strumenti attraverso cui le violenze di genere vengono messe in pratica e reiterate.

Raggiunta da Guerre di Rete, Bainotti spiega quali cambiamenti ha osservato nelle sue ricerche più recenti rispetto all’estensione del fenomeno e al modo in cui piattaforme e siti agevolano la diffusione di questo materiale: “C’è stato sicuramente un aumento consistente nel numero di utenti, per quanto sia difficile tenere traccia del dato preciso (ogni qualvolta viene buttato giù un gruppo se ne apre subito uno speculare). Quello che sicuramente ho riscontrato è che sono aumentati i bot attraverso cui generare i deepfake, e la pubblicità che ruota intorno a questi ‘prodotti’”, racconta Bainotti.

“Ci sono dei meccanismi di monetizzazione molto più espliciti e molto più capillari”, prosegue Bainotti. “Spesso per creare un deepfake vengono chiesti pochi centesimi di euro. Questo ci dà un’indicazione del fatto che sono comunque prezzi molto accessibili, che non richiedono un particolare investimento monetario. In più, sono stati messi a punto schemi per coinvolgere più persone e fidelizzare più utenti. Se inviti altri amici, per esempio, ottieni delle monete virtuali per scaricare altri deepfake. Vengono quindi riproposti schemi che avevamo già osservato su Telegram, che incitano a generare immagini di nudo come fosse un gioco (gamification), normalizzando queste pratiche”.

X, Google e non solo: tutto alla luce del sole

Tutto questo non avviene nel darkweb o in qualche meandro della rete, ma alla luce del sole. Google e altri motori di ricerca indirizzano il traffico verso siti che fanno profitto attraverso la generazione di deepfake sessuali che, nelle ricerche, vengono a loro volta indicizzati tra i primi risultati. Allo stesso modo le transazioni avvengono spesso su circuiti internazionali come Visa e Mastercard. Insomma, ogni attore coinvolto contribuisce in una certa misura a facilitare l’abuso.

Nell’agosto 2024, a otto mesi di distanza dai deepnude di Taylor Swift diventati virali su X, Google ha annunciato provvedimenti per facilitare le richieste di rimozione di contenuti espliciti non consensuali da parte delle vittime. Anche l’indicizzazione è stata rivista in modo tale che i primi risultati a comparire siano articoli di stampa che trattano l’argomento e non le immagini generate con l’IA. Eppure, una recente analisi dell’organizzazione anti-estremismo Institute for Strategic Dialogue (ISD) ha dimostrato che il modo più semplice per trovare immagini sessuali non consensuali rimane proprio quello della ricerca su Google, Yahoo, Bing e altri motori di ricerca. Almeno un risultato dei primi venti, infatti, è uno strumento per creare un deepnude.

Dall’acquisizione nel 2022 di Elon Musk, anche X è diventato un luogo dove questi strumenti proliferano. Secondo Chiara Puglielli e Anne Craanen, autrici del paper pubblicato da ISD, il social media di proprietà di Musk genererebbe il 70% di tutta l’attività analizzata dalle due ricercatrici, che coinvolge più di 410mila risultati.

Risulta problematico anche il form proposto da Google per chiedere la rimozione di un contenuto generato con l’IA: le vittime di image-based sexual abuse devono inserire nel modulo tutti i link che rimandano al contenuto non consensuale. Questo le costringe a tornare sui luoghi in cui si è consumato l’abuso, contribuendo a quella che notoriamente viene definita vittimizzazione secondaria, ovvero la condizione di ulteriore sofferenza a cui sono sottoposte le vittime di violenza di genere per mano di istituzioni ed enti terzi.

“Ancora oggi le piattaforme prevedono che sia a onere della vittima ‘procacciarsi’ le prove della violenza e dimostrare che il consenso era assente, quando invece si dovrebbe ragionare al contrario”, spiega ancora Semenzin. “Se denuncio la condivisione di una foto senza il mio consenso, la piattaforma dovrebbe rimuoverla lasciando semmai a chi l’ha pubblicata il compito di dimostrare che il consenso c’era. Questo sarebbe già un cambio di paradigma”.

Il Digital Services Act obbliga le piattaforme digitali con più di 45 milioni di utenti ad avere processi efficienti e rapidi per la rimozione di contenuti non consensuali o illegali. A fine ottobre, la Commissione Europea ha aperto delle procedure di infrazione contro Instagram e Facebook per aver aggiunto delle fasi non necessarie – note come dark patterns (modelli oscuri) – nei meccanismi di segnalazione di materiale illecito che potrebbero risultare “confuse e dissuasive” per gli utenti. Meta rischia una sanzione pari al 6% del fatturato annuo mondiale se non si conforma nei tempi dettati dalla Commissione.

Più in generale, è stato osservato in più studi che gli algoritmi di molte piattaforme amplificano la visibilità di contenuti misogini e suprematisti. Usando smartphone precedentemente mai utilizzati, tre ricercatrici dell’Università di Dublino hanno seguito ore di video e centinaia di contenuti proposti su TikTok e Youtube Shorts: tutti i nuovi account identificati con il genere maschile hanno ricevuto entro i primi 23 minuti video e immagini anti-femministi e maschilisti.

È stato riscontrato inoltre un rapido incremento se l’utente interagiva o mostrava interesse per uno dei contenuti in questione, arrivando a “occupare” la quasi totalità del feed delle due piattaforme. Nell’ultima fase dell’osservazione, il 76% di tutti i video su Tik Tok e il 78% di quelli proposti su YouTube mostravano a quel punto contenuti tossici realizzati da influencer della maschiosfera, il cui volto più noto è sicuramente Andrew Tate, accusato in più paesi di violenza sessuale e tratta di esseri umani.

Lacune legali

Dallo scorso 10 ottobre, in Italia è in vigore l’articolo 612 quater che legifera sulla “illecita diffusione di contenuti generati o alterati con sistemi di intelligenza artificiale”. È prevista la reclusione da uno a cinque anni per “chiunque cagioni un danno ingiusto a una persona, cedendo, pubblicando o altrimenti diffondendo, senza il suo consenso, immagini, video o voci falsificati o alterati mediante l’impiego di sistemi di intelligenza artificiale”.

Essendo trascorso poco più di un mese dalla sua entrata in vigore, non si hanno ancora sentenze che facciano giurisprudenza e che mostrino efficacia e limiti della norma. Quello che appare evidente è però che il testo si occupa di tutti i materiali generati con l’IA, senza entrare nello specifico dei casi in cui i contenuti manipolati sono sessualmente espliciti.

Non lo fa neanche l’articolo introdotto nel 2019 (612-ter), che seppur formuli il reato di diffusione di immagini intime senza consenso, conosciuto con il termine inappropriato di revenge porn, non amplia il raggio d’azione a quelle manipolate con l’IA. Come scrive Gian Marco Caletti, ricercatore in scienze giuridiche all’università di Bologna, questa esclusione “è apparsa fin da subito un aspetto critico, poiché nel 2019 era già ampiamente preventivabile l’affermarsi di questo uso distorto dell’intelligenza artificiale”.

La lacuna della legge del 2019 sembrava destinata a essere sanata grazie alla Direttiva europea sulla violenza di genere del 2024, che obbliga gli stati membri a punire le condotte consistenti nel “produrre, manipolare o alterare e successivamente rendere accessibile al pubblico” immagini, video o materiale analogo che faccia credere che una persona partecipi ad atti sessualmente espliciti senza il suo consenso.

Eppure, anche nell’articolo entrato in vigore in Italia lo scorso mese, il reato non viene letto attraverso la lente della violenza di genere: il testo mette potenzialmente insieme deepfake di politici creati, per esempio, per diffondere disinformazione in campagna elettorale e deepnude che presentano invece una matrice culturale ben precisa.

Se da un lato la legge presenta alcune lacune, è anche vero che la pronuncia del giudice è solo l’ultimo tassello di un iter che, nelle fasi precedenti, coinvolge molti più attori: dalle forze dell’ordine che ricevono la denuncia alle operatrici che lavorano nei centri anti-violenza.

La diffusione di image-based sexual abuse è un fenomeno che si muove sul piano culturale, sociale e tecnologico. E per questo motivo non può essere risolto solo con risposte legali. Il quadro normativo è fondamentale, anche allo scopo di criminalizzare la “produzione” di deepfake sessuali, ma non è sufficiente. Come si è visto già con l’introduzione della legge del 2019 sul revenge porn, questa non si è trasformata effettivamente in un deterrente alla condivisione di immagini esplicite non consensuali e, come riporta l’associazione Permesso Negato, la situazione è rimasta critica.

“Abbiamo bisogno di armonizzare gli strumenti a nostra disposizione: abbiamo una legge contro la condivisione di materiale non consensuale, di recente è stata introdotta quella contro i deepfake e dal 2024 c’è una direttiva europea sulla lotta contro la violenza di genere”, spiega ancora Bainotti. “Dobbiamo cercare di applicarle in modo che siano coerenti tra loro e messe a sistema. Nel caso italiano, credo che sia proprio questo il punto più carente, perché se abbiamo le leggi, ma allo stesso tempo abbiamo operatori di polizia o altri enti responsabili che non sono formati alla violenza di genere attraverso la tecnologia, la legge rimane fine a se stessa. Bisogna adottare un approccio sinergico, che metta insieme una chiara volontà politica, un’azione educatrice e una rivoluzione tecnologica”, conclude Bainotti.

Nuovi immaginari

Da alcuni anni, in Europa, stanno nascendo progetti non-profit che si occupano di tecnologia e spazi digitali da un punto di vista femminista. In Spagna, il collettivo FemBloc offre assistenza a donne e persone della comunità LGBTQ+ vittime di violenza online grazie al supporto interdisciplinare di esperti di sicurezza digitale, avvocati e psicologi. Tra le attività svolte c’è anche quella della formazione all’interno delle scuole contro la violenza di genere digitale, consulenze gratuite su come mettere in sicurezza i propri account e seminari aperti al pubblico.

Una realtà analoga è quella di Superrr, fondata in Germania nel 2019. Il loro lavoro – si legge sul sito – è quello di “assicurare che i nostri futuri digitali siano più giusti e più femministi. Tutte le persone dovrebbero beneficiare delle trasformazioni digitali preservando i propri diritti fondamentali”.

In un momento storico in cui la connessione tra “broligarchi tech” e Donald Trump è più evidente che mai, dove i primi si recano alla Casa Bianca per portare regalie e placche d’oro in cambio di contratti federali, sembra quasi ineluttabile che lo spazio digitale sia stato conquistato da un certo tipo di mascolinità: aggressiva, prepotente, muscolare. Eppure, c’è chi vuole ancora tentare di colonizzare questi spazi con nuovi immaginari politici e un’altra concezione dei rapporti di potere nelle relazioni di genere.